Конечно, учитывая погрязший в «вечных войнах» 21 века американский генералитет, у кого не возникло ощущения, что почти всё могло быть сделано лучше? И всё же, додуматься передать потенциальное уничтожение самой планеты (ядерным оружием) компьютерам? Я вот думаю, что же могло пойти не так?

Что ж, давайте позволим Клэру представить вам то, что может оказаться версией «Терминатора» нашего времени.

Том.

* * *

Понимая, что ковид-19 выводит из строя ошеломляющее число военнослужащих США, а современное оружие становится всё более смертоносным, американские военные всё чаще полагаются на умных роботов при проведении опасных боевых операций. Среди таких устройств, известных в войсках, как «автономные системы вооружений», роботы-часовые, беспилотники наблюдения за полем боя и автономные подлодки. Иными словами, пока что роботы просто заменяют стандартное оружие на традиционных полях сражений. Однако, теперь в гигантском прыжке веры, Пентагон стремится поднять этот процесс на новый уровень — заменяя не просто обычных солдат и их оружие, но потенциально адмиралов и генералов на роботизированные системы.

Надо признать, эти системы пока ещё на стадии разработки, но теперь Пентагон проталкивает их будущее развитие как вопрос национальной крайней необходимости. Каждый компонент современного генерального штаба — в том числе планирование боевых действий, сбор разведывательных данных, логистика, коммуникации и принятие решений — по последним планам Пентагона должен быть передан сложным устройствам из сенсоров, компьютеров и программного обеспечения. Всё это затем будет интегрировано в «систему систем», ныне получившую название Joint All-Domain Command-and-Control (Объединённое командование и управление всеми доменами) или JADC2 (поскольку акронимы остаются сутью военного бытия). В итоге этот сплав систем и в самом деле может выполнять большую часть функций, которые ныне исполняют американские генералы и их старшие офицеры.

Идея использования электронно-вычислительных машин для принятия решений командного уровня, конечно же, совсем не нова. По правде говоря, она появилась во время холодной войны, после появления межконтинентальных баллистических ракет с крайне малым временем подлёта, вот тогда и военные стратеги, и авторы научной фантастики начали представлять механические системы, которые контролировали бы подобное ядерное оружие в случае неспособности людей это сделать.

К примеру, в сатирическом фильме Стенли Кубрика 1964 года «Доктор Стренджлав» (Dr. Strangelove), вымышленный русский руководитель Димитрий Киссов раскрывает, что Советский Союз создал «машину Судного Дня», способную уничтожить всё человечество, и которая детонирует автоматически, если страна окажется под ударом американских ядерных сил. Усилия безумных офицеров антисоветчиков в ВВС США спровоцировать войну с Москвой успешно приводят к запуску механизма и грозят уничтожением человечества. В действительности, опасаясь неожиданной атаки подобного рода, Советы позже и на самом деле установили полуавтоматическую систему возмездия, которую назвали «Периметр», разработанную для запуска советских МБР в случае, если сенсоры определят ядерные взрывы, а вся связь с Москвой будет молчать. Некоторые аналитики считают, что улучшенная версия «Периметра» всё ещё действует, оставляя нас в совершенно реальной версии мира Стренджлава.

Ещё в одной научно-фантастической версии автоматических командных систем, фильме 1983 года WarGames с Мэттью Бродериком в главной роли подростка-хакера, представлен суперкомпьютер, называемый «План Ответа на Военные Операции» или WOPR (произносится «воппер») установленный в штаб-квартире Командования воздушно-космической обороны североамериканского континента (NORAD) в Чикаго. Когда персонаж Бродерика проникает в неё и начинает играть как он полагает в игру «Третья Мировая Война», компьютер делает вывод о том, что происходит реальная советская атака, и запускает ядерный удар отмщения. Хотя это и фантастика, но фильм точно показывает многие аспекты американской системы управления стратегическими ядерными силами (NC3), которая и тогда была, и сегодня остаётся высокоавтоматизированной.

Подобные устройства, и реальные, и воображаемые, по нынешним меркам были относительно примитивными, способными лишь определить, что произошло ядерное нападение и отдать приказ о катастрофическом ответе. Теперь же, в результате большого улучшения искусственного интеллекта (ИИ) и машинного обучения, эти роботы могут собирать и оценивать огромные количества сенсорных данных, быстро определять основные тенденции и модели и потенциально отдавать приказы боевым подразделениям где именно атаковать и когда.

Сжатие времени и человеческие погрешности

Подобное сжатие времени и расширение сенсорный данных могут применяться к любой форме боёв, но особенно к самой ужасающей — ядерной войне. Когда МБР были основным средством такой войны, у принимающих решения было до 30 минут между запуском ракеты и моментом её детонации, за это время можно было определить была ли потенциальная атака реальной или просто ложным срабатыванием спутника (как иногда случалось во время холодной войны). Времени могло быть и немного, но с появлением гиперзвуковых ракет этот отрезок времени может сократиться всего до пяти минут. В таких обстоятельствах не стоит ожидать, что даже самые подготовленные принимающие решения придут в информированному суждению о характере потенциальной атаки. Отсюда и обращение к (некоторым) автоматизированным системам принятия решений.

«Сжатие времени нападения ставит высшее руководство Америки в ситуацию, где существующие системы NC3 могут оказаться недостаточно быстрыми», утверждают военные стратеги Адам Лоутер и Куртис МакГиффин на ориентированном на безопасность вебсайте War on the Rocks. «Таким образом, может оказаться необходимо развивать систему, основанную на ИИ с предопределенными решениями ответа, которая определяет, принимает решения и направляет стратегические силы с такой скоростью, что проблема сжатия времени нападения не поставит США в невозможную ситуацию».

Сама мысль, что устройство с ИИ — по сути более разумная версия машины Судного Дня — следует наделить возможностями оценивать поведение врага, а затем на основе «предопределённых вариантов ответа» решать судьбу человечества, естественно, привела сообщество военных аналитиков в некое беспокойство (равно как и остальных). Тем не менее американские стратеги продолжают утверждать, что оценку поля боя и принятие решений — и в традиционной, и в ядерной войне — следует всё более делегировать машинам.

«Системы сбора и анализа информации с элементами искусственного интеллекта могут обеспечить способность объединять и детализировать огромные массивы данных из различных источников и разного географического положения, позволяя определить модели и выделить полезную информацию», отмечалось в ноябре 2019 года в краткой сводке подходов Пентагона, направленной в адрес научно-исследовательскую службу Конгресса США. «По мере усиления сложности систем с элементами искусственного интеллекта», добавлялось там, «алгоритмы ИИ смогут также быть способными обеспечить командующим выбор действенных планов на основе анализа поля боя в режиме реального времени, что в свою очередь даст возможность более быстрой адаптации к сложным событиям».

Ключевое здесь «выбор действенных планов на основе анализа поля боя в режиме реального времени». Это может оставить впечатление, что генералы и адмиралы (не говоря уж о главнокомандующем) по-прежнему будут принимать конечные решения на уровне «жизни и смерти» и в отношении собственных войск, и всей планеты. Однако учитывая подобное сжатие времени атаки в будущих боевых действий высокой интенсивности с Китаем и/или Россией, у людей может больше не оказаться времени или возможности самим анализировать поле боестолкновений, так что они придут к тому, что в оценках станут полагаться на алгоритмы ИИ. В результате командующие-люди просто окажутся в положении, когда будут одобрять решения, принятые машинами — и в итоге станут лишними.

Создание роботов-генералов

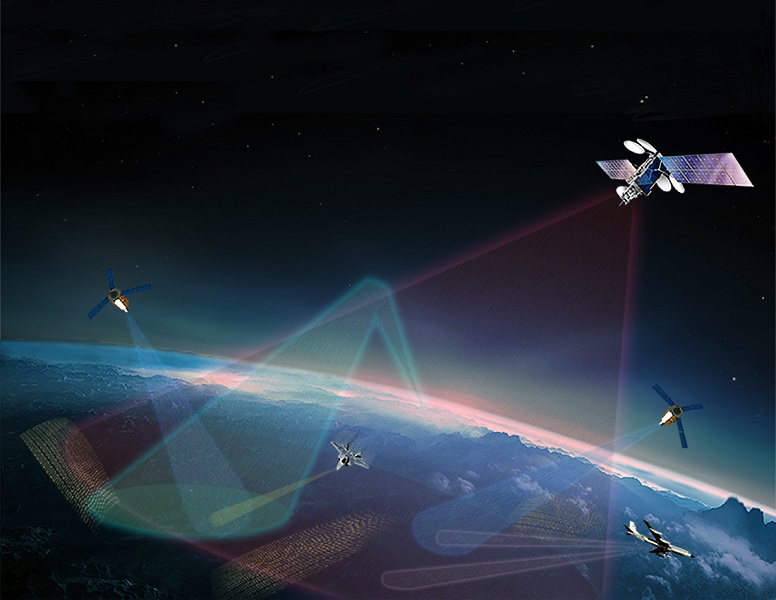

Несмотря на дурные предчувствия, которые могут у них возникнуть относительно будущего сохранения службы, высшие чины генералитета Америки движутся к тому, чтобы разработать и развернуть эти самые автоматические командные механизмы JADC2. Под наблюдение ВВС оказывается проводимое компьютером соединение устройств сбора разведданных о силах врага в режиме реального времени от огромного количества сенсорных устройств (спутников, наземных радаров, постов электронного прослушивания и так далее), переработки этих данных в действенную боевую информацию и обеспечение точных инструкций нападения для каждого боевого подразделения и систем вооружений, вовлечённых в конфликт — принадлежащих армии, флоту, морским пехотинцам или недавно сформированным космическим силам и кибер-командованию.

Из чего именно будет состоять JADC2 не очень известно, частично из-за того, что множество систем-компонентов всё ещё под грифом секретности, а частично из-за того, что значительная часть ключевых технологий ещё находится на стадии разработки. Наделённые ответственностью наблюдения за проектов, ВВС работают с «Локхид Мартин» и другими крупными оборонными подрядчиками в области дизайна и разработки ключевых элементов системы.

Одним из таких элементов является передовая система управления боевыми действиями (ABMS) — система сбора данных и распределения, которая предназначена для обеспечения пилотов истребителей поминутными данными о вражеских позициях и помощи в управлении их боевыми действиями. Другой ключевой компонент — армейская комплексная система управления боевыми действиями воздушно-ракетной обороны (IBCS), разработанная для связи радарных систем с пусковыми установками ПВО и ПРО и обеспечения их точными координатами цели. Со временем ВВС и их многочисленных подрядчики будут стремиться объединить ABMS и IBCS в гигантскую сеть систем, связывающих каждый сенсор, стрелка и командира в вооружённых силах страны — военный «интернет вещей», как говорят некоторые.

Чтобы проверить концепцию и дать пример того, как она может действовать в будущем, в августе в Германии армия провела артиллерийские учения с боевыми стрельбами, используя компоненты будущей системы JADC2. На первой стадии испытаний спутниковые снимки (предположительно) позиций российских войск были отправлены на наземный терминал армии, где программа ИИ под названием «Прометей» детализировала данные, «подсветив» вражеские цели. Далее другая программа ИИ под названием «Выстрел» подобрала оптимальное доступное вооружение армии для намеченных целей и направила информацию о них и точные координаты целей армейской усовершенствованной системе тактического информационного обеспечения полевой артиллерии (AFATDS) для немедленных действий, а командиры-люди могли выбрать, проводить их или нет. На учениях эти командиры обладали возможностью хоть чуточку подумать, в условиях реальных боевых действий они могли просто оставить все решения машинам, на что разработчики системы явно и рассчитывали.

В будущем армия планирует ещё более амбициозные тесты этой развивающейся технологии в соответствии с инициативой под названием проект «Слияние». Из того, что о нём говорится публично, в рамках проекта «Слияние» будут проведены ещё более сложные учения с привлечением спутников, истребителей ВВС с системами ABMS, вертолётов, беспилотников, артиллерии и боевых транспортных средств. В итоге всё это сформирует «архитектуру» JADC2, связывающую каждую боевую систему наблюдения и целеуказания с каждым боевым подразделением и системой вооружений — а генералам останется только сидеть и смотреть.

Почему роботы-генералы могут понять это неверно

Учитывая сложность современных боевых действий и проблему сжатия времени в будущих боевых конфликтах, стремление американских стратегов заменить людей-командиров на роботов определённо понимаемо. Роботы-генералы и адмиралы теоретически могут перерабатывать ошеломляющее количество информации в краткие периоды времени, одновременно отслеживая и дружественные, и вражеские силы, и определяя оптимальные пути противодействия врагу на будущих полях сражений. Но существует множество причин сомневаться в надёжности принимающих решения роботов и мудрости использования их вместо людей-офицеров.

Для начала многие из технологий всё ещё незрелы, почти все подвержены сбоям, которые невозможно предвидеть или понять. И не стоит забывать, что умелые профессионалы даже передовые алгоритмы могут одурачить или «обмануть».

Кроме того, в отличие от людей у системы принятия решений с ИИ будет отсутствовать способность оценивать намерения или контекст. Например, о чём говорит внезапное развёртывание вражеских войск — о неминуемом нападении, блефе или просто обычной ротации сил? Аналитики-люди могут использовать своё понимание нынешнего политического момента и действующих лиц, что поможет оценке ими ситуации. У машин такая способность отсутствует, и они могут предполагать самое худшее, начав боевые действия, которых можно было бы избежать.

Подобная проблема усугубиться «подготовкой» таких алгоритмов принятие решений по мере того, как они будут адаптироваться к военным ситуациям. Как программы распознавания лиц оказались подпорчены из-за того, что в процессе их настройки специалисты чрезмерно полагались на образы белых мужчин — что сделало их менее надёжными при распознавании, скажем, лиц женщин-афроамериканок — так и военные алгоритмы принятия решений, вероятно, будут искажены чрезмерным упором на ориентированные на бои сценарии, выбранные американскими военными-профессионалами для процесса подготовки. «Готовность к худшему сценарию событий» вполне естественна для подобных офицеров — в конце концов, кто желает оказаться пойманным врасплох возможной неожиданной вражеской атакой? — и такая пристрастность без сомнения станет частью «набора возможных действий», представленного принимающими решения роботами.

Объединённая в алгоритмы принятия решений, такая пристрастность может, в свою очередь, оказаться крайне опасной в любом будущем противостоянии между войсками США и России в Европе или американских и китайских сил в Азии. В итоге столкновение подобного рода может случиться в любой момент из-за недопонимания или локального инцидента, который быстро наберёт обороты — внезапное столкновение американских и китайских кораблей у Тайваня, например, или между американским и российским патрулями в одном из государств Прибалтики. Ни одна сторона, возможно, и не намеревается начать полномасштабный конфликт, руководители каждой из сторон могут перейти к переговорам о прекращении огня. Но помните, это больше не будет простым в конфликтах людей. После подобного инцидента JADC2 может определить какие-то действия врага, которые посчитает неизбежным риском для сил союзников и немедленно начнёт всеобщую атаку американскими самолётами, ракетами и артиллерией с эскалацией конфликта и исключением каких-либо шансов на быстрое переговорное урегулирование.

Подобные перспективы становятся поистине пугающими, когда на кону стоит начало ядерной войны. Трудно представить какой-либо конфликт между крупными державами, начинающийся как ядерная война, но намного легче предвидеть сценарий, при котором великие державы — после того, как окажутся втянутыми в конфликт с применением обычных видов оружия— дойдут до точки, когда одна или другая сторона рассмотрит применение ядерных сил ради того, чтобы избежать поражения. На самом деле американская военная доктрина всегда придерживалась возможности использования так называемого тактического ядерного оружия в ответ на массированное советское (теперь российское) наступление в Европе. Российская военная доктрина, и это допускается, тоже включает подобные варианты. При таких обстоятельствах будущая JADC2 может неверно интерпретировать действия врага как сигнал о подготовке к ядерному удару и отдать приказ ядерным силам США о превентивном ударе, таким образом начав Третью Мировую Войну.

Война отвратительна и жестока, а учитывая почти два десятка лет провальных конфликтов, которые получили название «войны с террором» с тысячами жертв среди американцев (и физических, и психологических), легко понять почему энтузиасты применения роботов так жаждут увидеть, как у американских «поджигателей войны» возобладает иной тип менталитета. Для начала, утверждают они, особенно в мире пандемии, это всего лишь замена на поле боя людей-солдат солдатами-роботами, что сократит человеческие жертвы (по крайней мере среди воюющих). Конечно, в этом утверждении не учитывается, что у солдат-роботов и беспилотных самолётов отсутствует способность различать на поле боя воюющих и не воюющих, так что им невозможно доверять соблюдение законов войны или международного гуманитарного права — которые, по крайней мере теоретически, защищают гражданских лиц от ненужного вреда — и потому их следует запретить.

Всё это может проявиться на будущих полях сражений, а вот замена генералов и адмиралов роботами — другое дело. В большом количестве возникают не только законные и моральные аргументы, поскольку жизни масс гражданского населения могут оказаться в опасности из-за принятых компьютером боевых решений, но к тому же нет никаких гарантий, что американские «джи-ай» понесут меньшие потери на полях сражений. Возможно, пора Конгрессу задать некие неприятные вопросы о целесообразности автоматизации принятия боевых решений прежде, чем страна вольёт миллиарды долларов налогоплательщиков в авантюру, которая и в самом деле может привести к концу того мира, которые мы знаем. Возможно, пора руководителям Китая, России и нашей страны ограничить или запретить развёртывание гиперзвуковых ракет и других вооружений, которые сжимают время принятия решений о жизни и смерти человечества до нескольких минут, таким образом оправдывая автоматизацию подобных судьбоносных оценок