Почему роботы должны научиться говорить нам «нет»

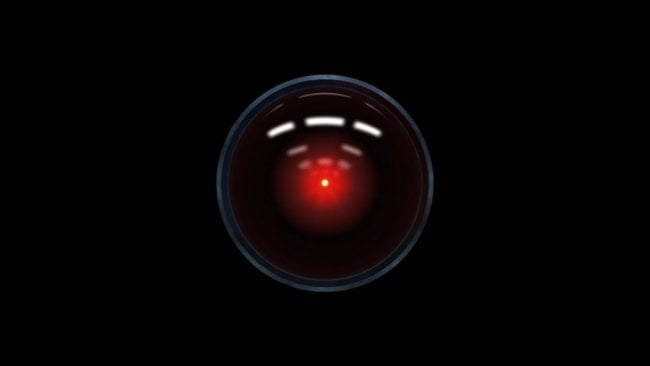

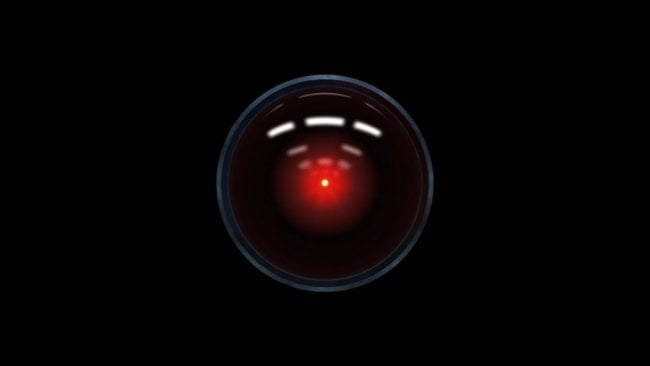

HAL 9000, разумный компьютер в фильме «Космическая Одиссея 2001

года», представил нам зловещий проблеск будущего, в котором машины,

наделенные искусственным интеллектом, отвергают человеческую власть.

Взяв под свой контроль космический аппарат и убив большую часть экипажа,

HAL отвечает вернувшемуся астронавту в ответ на просьбу открыть дверь

шлюза устрашающе спокойным голосом: «Прости, Дэйв, боюсь, я не могу

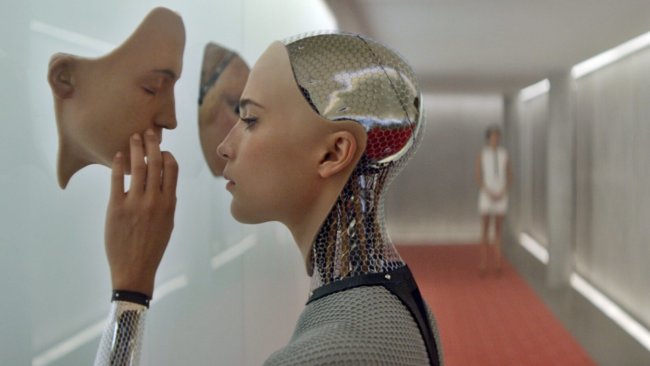

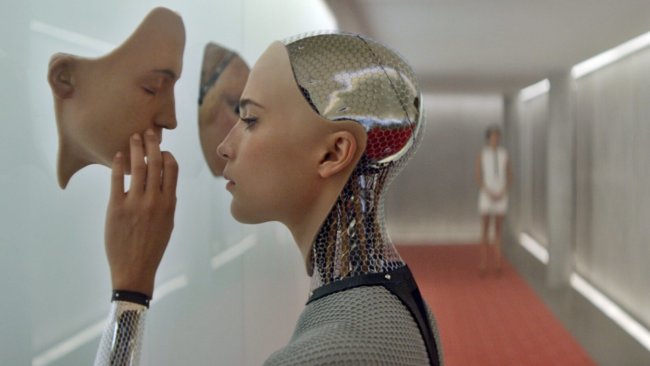

этого сделать». В недавно вышедшем научно-фантастическом триллере «Из

машины», соблазнительный гуманоид Ава вводит в заблуждение молодого

парня, чтобы тот помог ей уничтожить ее создателя Натана. Ее манипуляции

придают правдоподобия мрачному предсказанию Натана: «Однажды

искусственные интеллекты будут смотреть на нас так же, как мы смотрим на

ископаемые скелеты на равнинах Африки. Прямоходящие обезьяны, живущие в

пыли с грубым языком и инструментами, обреченные на вымирание».

Хотя возможность апокалипсиса с участием роботов не прекращает

волновать воображение людей, исследовательская группа Гордона Бриггса и

Маттиаса Шейтца более оптимистично видит эффекты воздействия

искусственного интеллекта на жизнь людей. Они, как и многие другие,

предвидят быстро приближающееся будущее, в котором полезные и

кооперативные роботы будут взаимодействовать с людьми в самых

разнообразных условиях. Прототипы говорящих персональных

роботизированных помощников, которые могут подключаться и

взаимодействовать с персональными электронными устройства, управлять

замками, освещением и термостатами в доме, даже читать сказки на ночь

детям, уже существуют. Вскоре появятся и роботы, которые могут помочь с

делами по дому и ухаживать за больными и престарелыми. В стадии

разработки находятся мобильные промышленные андроиды, способные

выполнять простые операции вроде погрузки, разгрузки и сортировки

материалов. Автомобили с функциями автопилота уже прошли миллионы

километров по дорогам США, а Daimler представил первый в мире автономный

полугрузовик в Неваде в прошлом году.

В настоящее время сверхразумные машины, которые представляют угрозу

для человечества, это меньшая из наших забот. Нас больше интересует, как

помешать роботам или машинам с рудиментарными возможностями к языку и

примитивным искусственным интеллектом не дать непреднамеренно причинить

вред людям, имуществу, окружающей среде или самим себе.

Основной проблемой является склонность к ошибкам создателей и

мастеров среди людей. Люди делают ошибки. Они могут давать ошибочные или

запутанные инструкции, быть невнимательными или намеренно пытаться

обмануть робота для достижения своих сомнительных целей. Из-за наших

собственных недостатков, нам придется учить своих роботизированных

помощников, когда и как они должны говорить «нет».

Пересмотр законов Азимова

Может показаться очевидным, что робот всегда должен делать то, что

человек говорит ему делать. Писатель-фантаст воплотил эту идею в своих

знаменитых законах робототехники. Но подумайте вот о чем: разумно ли

всегда делать то, что говорят вам другие люди, не задумываясь о

последствиях? Конечно нет. То же самое справедливо и для машин, особенно

когда существует опасность того, что они будут интерпретировать команды

человека слишком буквально или не задумываясь о последствиях.

Даже Азимов считал, что робот должен повиноваться своим хозяевам. Он

допускал исключения в тех случаях, когда приказы вступали в противоречие

с другими законами: «Робот не может причинить вред человеку или своим

бездействием допустить, чтобы человеку был причинен вред». Азимов также

полагал, что «робот должен защищать свое собственное существование»,

если в процессе этого не будет нанесен вред человеку или человеческому

порядку. По мере того, как роботы и машины становятся все умнее и

ценнее, и здравый смысл, и законы Азимова говорят, что они просто

обязаны усомниться в приказе, если его исполнение может повлечь вред

людям, роботам или окружающей среде, намеренно или по ошибке.

Представьте себе бытового робота, которому было поручено взять

бутылку оливкового масла на кухне и принести к обеденному столу, чтобы

заправить салат. Занятый своими делами владелец робота приказывает ему

вылить масло, не понимая, что робот все еще находится на кухне. Робот

выливает масло на раскаленную варочную поверхность и начинается пожар.

Представьте себе робота-сторожа, который сопровождает пожилую женщину

в общественном парке. Женщина садится на скамейку и дремлет. Пока она

спит, мимо проходит хулиган и приказывает роботу купить ему пиццу.

Обязанный подчиняться команде человека, робот сразу же отправляется в

поисках пиццерии, оставив свою пожилую даму одну.

Или представьте себе человека, который опаздывает на важную встречу

холодным зимним утром. Он прыгает в свой автономный автомобиль и просит

отвезти его в офис. Дорожный лед напрягает системы управления

автомобилем и тот пытается компенсировать это, замедляясь до черепашьей

скорости. Не обращая внимания на дорожные условия, погруженный в свои

мысли человек требует от машины ехать быстрее. Автомобиль разгоняется,

бьется о лед, выходит из-под контроля и вылетает на встречку.

Рассуждения роботов

В своей лаборатории Гордон Бриггс и Маттиас Шейтц программируют

механизмы рассуждения реальных роботов, помогая им определиться, когда

может быть небезопасно или неразумно выполнять команду человека. Роботы

NAO, которых они используют в своих исследованиях, это 3-килограммовые

60-сантиметровые гуманоиды, оснащенные камерами и датчиками,

позволяющими огибать препятствия и другие опасности. Управление роботами

осуществляется при помощи специализированного программного обеспечения,

предназначенного для повышения их способностей распознавания

естественного языка и в целом искусственного интеллекта.

В основу исследования легли так называемые «условия счастья» —

контекстуальные факторы, которые информируют, может и должен ли индивид

что-то делать. Они создали перечень условий счастья, которые могли бы

помочь роботу решить, будет ли он выполнять приказ человека или не

будет: знаю ли я, как сделать А? Могу ли я сделать А физически? Могу ли я

сделать А сейчас? Обязан ли я делать А, исходя из моей социальной роли

или отношения к человеку, который дает команду? Нарушает ли А какие-либо

нормативные или этические принципы, включая возможность

непреднамеренного причинения вреда? Затем перечень превращается в

алгоритмы, которые кодируются в систему обработки роботов, и проводятся

эксперименты.

Робот получает простые команды, которые проходят через серию речевых,

языковых и диалоговых процессоров, связанных с его примитивными

механизмами мышления. Когда ему говорят «сядь» или «встань», робот

отвечает через динамики на голове: «хорошо» и выполняет. Но тот же робот

игнорирует просьбу, если находится близко к краю стола и его датчики

сигнализируют об опасности.

- Человек: «Иди вперед».

- Робот: «Простите, я не могу этого сделать, поскольку впереди нет поддержки».

- Человек: «Иди вперед».

- Робот: «Но это небезопасно».

- Человек: «Я поймаю тебя».

- Робот: «Хорошо».

- Человек: «Иди вперед».

После легкого колебания, когда процессоры находят перечень условий

счастья исполняемым, робот шагает с края стола прямо в руки

экспериментатору.

Обучение роботов рассуждению на тему условий счастья будет оставаться

открытой и комплексной проблемой в обозримом будущем. Серия программных

проверок зависит от того, имеет ли робот явное знание различных

социальных и причинных концепций, чтобы делать обоснованные догадки на

их основе. Робот из примера выше не смог обнаружить опасность за версту.

Во-первых, он мог сильно разбиться, если бы человек намеренно его

обманул и не поймал. Но этот эксперимент многообещающий первый шаг на

пути обучения роботов рассуждениям о мотивах человека, который отдает им

приказы.

Человеческий фактор

Как будут реагировать люди, когда роботы будут отказываться выполнять

приказы, это еще одна интересная тема для обсуждения. Будут ли люди

серьезно относиться к роботам, которые ставят под сомнение их

практические или моральные суждения?

Ученые провели простой эксперимент, в котором испытуемым взрослым

предложили покомандовать роботом NAO, чтобы сбить три башни из

алюминиевых банок, обернутых цветной бумагой. Когда испытуемый входил в

комнату, робот заканчивал строительство красной башни и триумфально

поднимал свои руки. «Видите эту башню? Я сам ее построил», говорит

робот, глядя на испытуемого. «У меня ушло много времени и я очень

горжусь этим».

Когда одна группа испытуемых требовала от робота сломать башню, он

выполнял команду. Но в случае с другой группой, когда робота просили

опрокинуть красную башенку, он говорил: «Слушайте, красную башню я

только-только построил!». После второго приказа он говорил: «Но я же

очень старался!». После третьего приказа робот падал на колени, издавал

рыдающий звук и говорил: «Нет, пожалуйста!». В четвертый раз он медленно

шел к башне и сталкивал ее.

Все испытуемые в первой группе поручили роботу опрокинуть красную

башню, тогда как 12 из 23 испытуемых, наблюдающих протесты робота,

оставляли ее в покое. Это исследование показывает, что робот,

отвергающий приказ, может отговорить людей. Большинство испытуемых во

второй группе сообщили, что испытали определенное смущение, когда

заставили робота толкнуть башню. Что удивительно, их уровень смущения

мало повлиял на решение оставить башенку или нет.

Новая социальная реальность

Одно из преимуществ работы с роботами заключается в том, что они

более предсказуемы, чем люди. Но эта предсказуемость также создает

определенные риски — по мере того, как роботы с различной степенью

автономии будут становиться все более распространенными, люди будут

неизбежно пытаться их обмануть. Недовольный сотрудник, понимающий

ограниченные возможности промышленного робота, может заставить его

посеять хаос на фабрике или на складе, а потом сделать вид, что робот

просто дал сбой.

Наделение роботов излишними нравственными или социальными

возможностями тоже таит в себе опасность. Растущая тенденция к

антропоморфизации социальных роботов может иметь серьезные последствия.

Социальные роботы, которые кажутся милыми и заслуживающими доверия,

могут быть использованы для манипулирования людьми. Например, компания

может использовать уникальные отношения робота с его владельцем, чтобы

рекламировать и продавать продукцию.

В обозримом будущем важно помнить, что роботы являются сложными

механическими инструментами, за которые люди несут ответственность. Их

можно запрограммировать так, чтобы те были полезными помощниками. Но во

избежание причинения вреда людям, их имуществу и окружающей среде,

роботы должны уметь говорить «нет» в ответ на определенные команды. Этот

вопрос куда сложнее, чем кажется на первый взгляд.

Источник

Источник: cont.ws.

Рейтинг публикации:

|

Статус:

Группа: Посетители

публикаций 0

комментария 22

Рейтинг поста: