10 пугающих технологий будущего, от которых нам лучше отказаться

4-06-2016, 20:25. Разместил: sasha1959

10 пугающих технологий будущего, от которых нам лучше отказаться

Чем глубже мы погружаемся в 21 первый век, тем отчетливее проступают фантастические возможности, которые перед нами открываются. И тем отчетливее мы испытываем мрачные чувства, когда о них думаем. Перед вами десять пугающих технологий, которых лучше бы никогда не существовало. Когда вы с ними ознакомитесь, вам станет очевидно, что многим из этих технологий могли бы найти хорошее применение. Но важно провести разделительную черту между технологией как таковой и тем, как ее можно использовать.

Взять, к примеру, нанотехнологии. По мере разработки, их можно использовать, чтобы положить конец постоянному дефициту, очистить окружающую среду, переделать биологию человека. Но также их можно использовать для весьма быстрого уничтожения нашей планеты. Так что когда настанет время разрабатывать и использовать эти футуристические технологии, нам придется подойти к этому со всей ответственностью. Возможно, мы придем к мысли, что отдельная серия технологических разработок и сопряженные с ней риски не стоят преимуществ. Например, искусственный сверхинтеллект.

Некоторые технологии объективно опасны. Вот что говорит по этому поводу Патрик Лин, директор Ethics + Emerging Sciences Group из Калифорнийского политехнического государственного университета:

«Идея того, что технологии нейтральны или не имеют отношения к нравственности, это миф, который нужно развеять. Дизайнер может наделить этикой создание, даже если этот предмет не имеет никакого морального агента сам по себе. Эта функция может быть слишком незаметной в большинстве случаев, но некоторые технологии были рождены от зла и не имеют благотворного применения, например, газовые камеры. Более того, хотя технологии могут быть изначально хорошими или плохими, любой согласится с тем, что у большинства технологий имеются как хорошие, так и плохие варианты применений. Если вероятность применения технологии во имя зла выше, чем во имя добра, возможно, такую технологию не стоит разрабатывать».

Военные нанотехнологии

Едва ли что-нибудь еще может положить конец нашему правлению на Земле быстрее, чем военные — или сильно испорченные — нанотехнологии молекулярной сборки.

Эта угроза проистекает из двух чрезвычайно мощных сил: неконтролируемое самовоспроизводство и экспоненциальный рост. Нигилистическое правительство, негосударственный агент или частное лицо может разработать микроскопические машины, которые поглотят критически важные ресурсы нашей планеты со скоростью лесного пожара (очень быстро), при этом плодясь в огромном количестве и оставляя бесполезные побочные продукты на своем пути — футурологи называют этот сценарий «серой слизью».

Теоретик нанотехнологий Роберт Фрейтас предложил несколько возможных вариантов появления губительных для планеты нанотехнологий, включая серую пыль, серый планктон, серые лишайники и так называемые убийцы биомассы. Серая пыль закроет нас от солнечного света; серый планктон будет состоять из выращенных на дне океана репликаторов, которые поедят всю наземную богатую углеродом экологию; серые лишайники уничтожат наземную геологию, а убийцы биомассы атакуют разнообразные организмы.

По мнению Фрейтаса, худший сценарий «глобальной экофагии» займет порядка 20 месяцев, чего будет более чем достаточно, чтобы сконструировать эффективную защиту. Под защитой Фрейтас имеет в виду контрмеры в виде самореплицирующихся нанотехнологий или систему, которая выводит из строя внутренний механизм наноботов. С другой стороны, мы могли бы развернуть «активные щиты» заранее, но большинство экспертов в области нанотехнологий сходятся в том, что это будет бесполезно. Следовательно, придется разрабатывать и поддерживать мораторий на создание боевых нанотехнологий.

Разумные машины

Однажды мы подарим машинам искусственное сознание, это уже принимается как само собой разумеющееся. Но прежде чем двигаться вперед к такому будущему, нам нужно очень серьезно подумать. Возможно, будет слишком жестоким строить функциональный мозг внутри компьютера — и это касается как животных, так и человеческих эмуляций.

Еще в 2003 году философ Томас Метцингер утверждал, что было бы чудовищно неэтично разрабатывать программное обеспечение, которое может испытывать страдания:

«Что бы вы сказали, если бы кто-нибудь пришел и сказал: «Мы хотим генетически изменять умственно отсталых человеческих младенцев! По некоторым угодным научному прогрессу причинам, нам нужны младенцы с определенными когнитивными и эмоциональными отклонениями, чтобы изучать их послеродовое психологическое развитие — нам срочно нужны средства для этого важного и новаторского типа исследований!». Вы бы сочли, что это не только абсурдная и сомнительная, но и опасная идея. Ее не пропустила бы ни одна комиссия по этике в демократическом мире. Однако нынешние комитеты по этике не видят, что первые машины, удовлетворяющие минимальным условиям сознательного опыта, могут быть такими же умственно отсталыми младенцами. Они могут страдать от всех видов функционального и репрезентативного дефицита. И они будут субъективно ощущать этот дефицит. Более того, у них не будет никакой защиты и никаких представителей в комитетах по этике».

Футуролог Луи Хельм соглашается с ним:

«Компьютеры особенно хороши тем, что могут подсчитать сумму миллионов колонок в таблице и не устать, не соскучиться. Поскольку мы планируем использовать искусственный интеллект в качестве замены умственного труда, думаю, было бы безнравственно создавать разумные программы. Заточить сознательное существо в машине и заставить его работать на вас — это практически рабство. Кроме того, сознание — хрупкая штука. Несколько неправильно закодированных генов у человека могут вызвать синдром Дауна, шизофрению, аутизм или эпилепсию. Каково это: обладать неправильно запрограммированной формой сознания? Например, несколько хорошо спонсируемых разработчиков ИИ захотят воссоздать разум человека в машинах за счет имитации биологической структуры мозга человека. Я ожидаю и даже немного надеюсь, что эти первые попытки моделирования будут слишком грубыми, чтобы действительно выгореть. Но в случае «успеха», первые результаты наверняка породят странное, неприятное и обрезанное состояние субъективного опыта. Как программист, я против самосознательного искусственного интеллекта. Не потому что это будет не круто. А потому что я морально против рабства, пыток и плохого кода».

Искусственный сверхинтеллект

Как заявил Стивен Хокинг в начале этого года, искусственный интеллект может быть нашей худшей ошибкой в истории. Много раз мы обсуждали то, что появление сверхчеловеческого интеллекта может стать катастрофой. Появление систем, которые намного быстрее и умнее нас, откинет нас на задний план. Мы окажемся во власти того, что пожелает искусственный сверхинтеллект — и непонятно, удастся ли нам создать дружественный искусственный интеллект. Нам придется решить эту проблему как можно быстрее, иначе развитие искусственного сверхинтеллекта может положить конец человеческой расе.

Путешествия во времени

Не то чтобы я сильно верил в возможность путешествий во времени (разве все мы не путешествуем во времени прямо сейчас?), но сбрасывать ее со счетов не стоит. Более того, нам нужно держаться от нее подальше.

Путешествия во времени могут быть чертовски опасными. Любой фильм про запутанные временные линии расскажет вам о потенциальных опасностях, включая неприятные парадоксы. И даже если некая форма квантовых путешествий во времени станет возможна — когда создаются совершенно новые и раздельные временные линии — культурный и технологический обмен между разными цивилизациями вряд ли может закончиться хорошо.

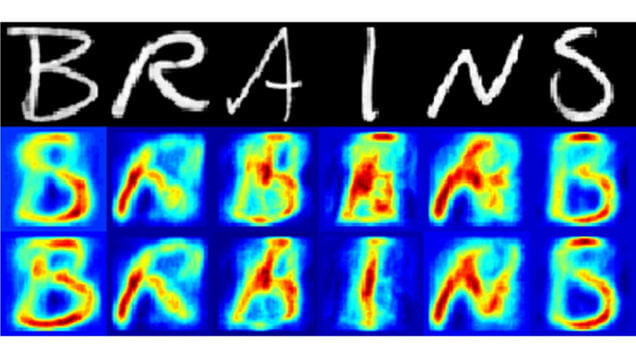

Устройства для чтения мыслей

Перспектива существования машин, которые могут читать мысли и воспоминания людей на расстоянии и не очень, с их согласия и без, вызывает опасения. Но такое вряд ли будет возможно, пока человеческий мозг не станет более тесно интегрирован с сетью и другими каналами связи.

В прошлом году, например, ученые из Нидерландов использовали данные сканирования мозга и компьютерные алгоритмы, чтобы определить, на какие буквы смотрит человек. Этот прорыв показал возможность реконструкции человеческих мыслей с беспрецедентным уровнем детализации третьим лицом — включая то, что мы видим, о чем думаем, что помним. Если такие устройства попадут в лапы тоталитарного режима или полицейского государства, жизнь станет невозможной и невыносимой. Мир будет похож на оруэлловский, в котором будут наказывать даже за преступления, совершенные в мыслях.

Устройства для взлома мозга

Существует возможность, что наше сознание можно будет изменить, вместе с нашими знаниями и воспоминаниями. Как только мы получим чипы в мозг и все барьеры падут, наше сознание будет открыто для всего Интернета и всех его зол.

Первый шаг по направлению к этой цели мы уже сделали. Не так давно международная группа неврологов начала эксперимент, который позволит участникам осуществлять связь от мозга к мозгу через Интернет. Классно, подумаете вы, но такая техническая телепатия открывает целый ящик Пандоры. Злоумышленник может получить возможность к модификации воспоминаний и намерений жертвы. А что будет, если такую возможность получат целые организации или параноидальные правительства?

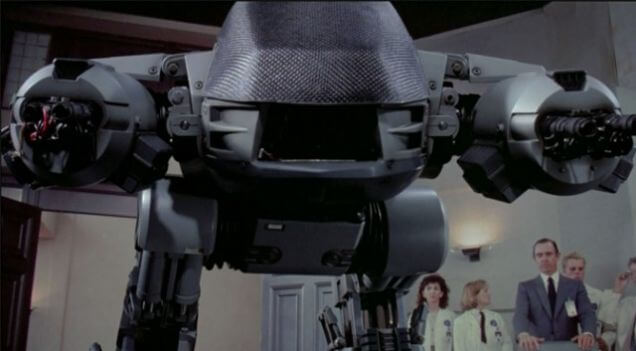

Автономные роботы для уничтожения людей

Потенциал автономных машин, убивающих людей, пугает всех — и, наверное, это первый пункт на повестке дня, с которым нужно начинать бороться.

Вот что говорит футуролог Майкл Латорра:

«У нас пока нет машин, которые обладают общим интеллектом, близким к уровню человека. Но для операций автономных роботов с летальными способностями интеллект человеческого уровня не требуется. Строительство всевозможных роботизированных военных аппаратов уже идет полным ходом. Роботы-танки, самолеты, корабли, подлодки, роботы-солдаты — все это возможно уже сегодня. В отличие от беспилотных дронов с дистанционным управлением, военные роботы могут определять цели и уничтожить их без человеческой указки и приказа стрелять. Опасность такой технологии должна быть очевидна, но не должна сводиться только к угрозе «дружественного огня», когда роботы случайно убивают людей на своей стороне конфликта или даже невинных граждан. Куда большая опасность скрывается в международной гонке вооружений, которая может развернуться, если какая-нибудь страна начнет строить автономных боевых роботов. После нескольких циклов улучшений, гонка создания еще более мощных военных роботов может перейти порог, когда новейшее поколение автономных роботов сможет побороть любую военную систему под управлением людей. И тогда, случайно или намеренно, человечество может поставить себя в ужасное положение, окажется раздавленными жертвами боевых роботов».

Боевые патогены

Это еще одна тема, которая волнует многих. В 2005 году Рэй Курцвейл и Билл Джой отмечали, что публикация геномов смертельных вирусов для всего мира будет убийственным рецептом. Всегда найдется идиот или кучка фанатиков, которые возьмут эту информацию на вооружение и либо реконструируют вирус с нуля, либо модифицируют существующие вирусы, сделав их еще более опасными, а потом выпустит в мир. Было подсчитано, например, что модифицированный птичий грипп мог бы уничтожить половину земного населения. А ученые из Китая и вовсе совместили птичий и свиной грипп, создав настоящего мутанта. Целью их, конечно, было понять, узнать врага и разработать возможные контрмеры, прежде чем вспыхнет настоящая пандемия. Но всегда есть опасность, что вирус сбежит из лаборатории и посеет хаос среди людей. Или что его возьмут на вооружение и спустят с цепи.

Пришло время задуматься об этой мрачной возможности до того, как случится нечто ужасное.

Виртуальные тюрьмы и пытки

Какими будут пытки и тюрьмы, если люди смогут жить в течение сотен или тысяч лет? Что будет с заключенными, если их разумы загрузить в виртуальный мир? Этик Ребекка Роач занимается исследованием этих ужасных сценариев:

«Преимущества бессмертия очевидны — но вместе с ним может увеличиться мера наказания. Если тридцать лет заключения сочтут слишком мягким наказанием, преступнику могут дать и пожизненное с учетом увеличенной продолжительности жизни. Пожизненное заключение превратится в несколько сотен лет, например. Правда, обществу может быть дороже содержать таких преступников. Но если же увеличение продолжительности жизни станет доступно повсеместно, долгожители несомненно внесут свой вклад в виде долгоживущей рабочей силы.

Загрузка сознания совершившего преступление и ускорение его в миллион раз позволит ему «отработать» преступление с наказанием в 1000 лет за восемь с половиной часов. Это будет дешевле, чем содержать преступника на деньги налогоплательщиков ту же 1000 лет. Вслед за этим концентрированным наказанием может последовать реабилитация, также на несколько часов».

Это ужасно. Надеемся, человечество на такое не согласится.

Создание ада

Этот вариант похож на предыдущий. Некоторые футурологи предвидят создание рая— использование передовых технологий, включая загрузку сознания и виртуальную реальность, которые превратят Землю в парадиз. Но если вы можете создать рай, вы можете создать и ад. Эта перспектива особенно пугает, если учесть неопределенную продолжительность жизни, а также практически безграничные возможности психологического и физического наказания. Сложно представить, что кто-то в принципе захочет разрабатывать такую вещь. Но этим кем-то может быть искусственный сверхинтеллект. Вы же помните проблему Василиска Роко?

Вернуться назад