Прикажет нажать на "ядерную" кнопку: Экс-чиновник Пентагона предположил "кошмарный сценарий"

2-09-2019, 08:08. Разместил: Редакция ОКО ПЛАНЕТЫ

Прикажет нажать на "ядерную" кнопку: Экс-чиновник Пентагона предположил "кошмарный сценарий"

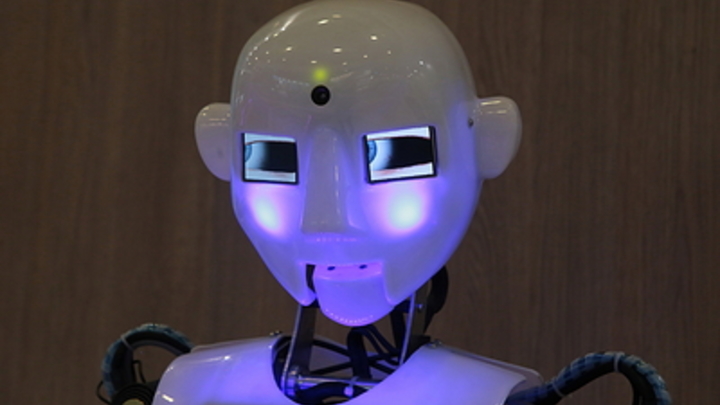

Бывший замминистра обороны США Роберт Уорк предположил, как пишет Breaking Defense "кошмарный сценарий" будущего при использовании систем искусственного интеллекта военными. И экс-чиновник Пентагона не исключил того, что использующий ИИ компьютер может просто приказать человеку нажать на "ядерную" кнопку.

"Забудьте о Терминаторе. Не беспокойтесь о танках-роботах или истребителях. Настоящая опасность искусственного интеллекта (ИИ), заключается не в оружии роботов", - предупреждает издание Breaking Defense со ссылкой на бывшего заместители министра обороны США Роберта Уорка.

Уточняется, что речь идет о компьютере, который использует ИИ для обработки разведывательных данных и не исключается того факта, что он может приказать человеку нажать кнопку "огонь" - особенно когда речь идет о ядерных ракетах.

Ворк называет это "смертоносные автономные системы оружия".

"Они определяют оружие, которое не контролируется или не зависит от человеческого направления, - поясняет Уорк, - не контролируется в ходе операций на поле боя и само-ориентируется".

При этом экс-чиновник Пентагона заявляет, что такого оружия не существует и предполагает, что оно "может быть даже технически не осуществимо".

Но в то же время Уорк все же предположил "кошмарный сценарий", как пишет издание. И речь идет именно об ИИ, который управляет нанесением ядерного удара.

"Представьте, что в ядерной системе командования и управления есть прогностическая система ИИ, которая запускается по определенным параметрам", - обратил внимание Уорк, отметив, что это - "гораздо более тревожная перспектива, чем все, что вы можете представить с точки зрения индивидуального оружия".

Бывший замминистра обороны США предупреждает, что опасно слепо доверять анализу интеллекта ИИ.

Вернуться назад