American Conservative: какие ловушки ИИ готовит для США?

4-09-2019, 11:12. Разместил: Редакция ОКО ПЛАНЕТЫ

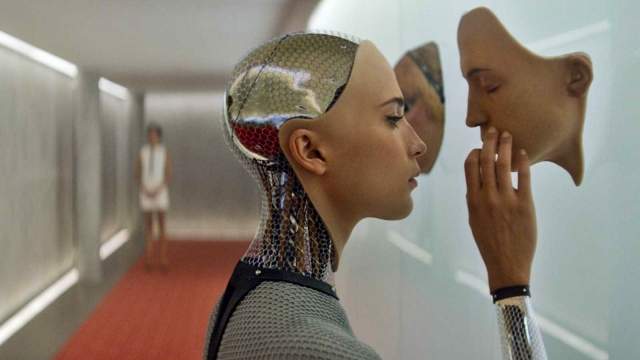

Если мы поспешим внедрить ИИ, мы предоставим жёстким алгоритмам возможность решать вопросы войны и мира. И именно поэтому наши «вечные войны» могут стать поистине бесконечными.

Максим Исаев, 4 сентября 2019, 08:30 — REGNUM Крупнейшие мировые державы продолжают гонку вооружений в сфере искусственного интеллекта (ИИ). В течение следующих нескольких лет Китай рассчитывает разместить в спорных водах Южно-Китайского моря флот беспилотных подводных лодок. Россия провела испытания своего роботизированного танка на поле боя в Сирии и, как сообщается, работает над созданием автономных ядерных подводных лодок. Со своей стороны, США проводят испытания роя автономных беспилотников, пишет Дмитрий Саймс — младший в статье для издания The American Conservative.

Это развитие может привести к серьёзным последствиям, не только с точки зрения способа ведения войны, но и с точки зрения будущей внешней политики США. По мере того как ИИ постепенно превращается в важную составную часть современных войн, США становится всё труднее выбраться из затяжных конфликтов и избежать новых. Короче говоря, ИИ может стать фактором, удерживающим наших военных в ловушке вечных конфликтов.

Нетрудно перечислить преимущества использования ИИ в конфликте. Роботы могут обрабатывать большие объёмы данных, нежели люди. В то же время, учитывая то, что скорость современных конфликтов постоянно увеличивается, системы ИИ позволили бы сократить время реагирования на меняющиеся условия, а также снизить зависимость военных от человеческого персонала, что в конечном итоге привело бы к снижению потерь и сокращению военных расходов.

К сожалению, есть и другая сторона медали. Технологии ИИ могут также вселить в высшее военное руководство чрезмерную уверенность. Когда люди перестанут принимать участие в боевых действиях, они могут прийти к выводу, что цена войны уменьшилась. Конечно же, это не так.

Геополитические последствия войн сложнее измерить, чем военные потери, но они не менее значимы. В конце концов, последние 20 лет иностранных вмешательств доказывают это. Всё это привело к ослаблению безопасности США, в то время как целые страны превратились в убежища для джихадистских групп, таких как ИГИЛ (организация, деятельность которой запрещена в РФ). В ЕС хлынул массовый поток беженцев, а Северная Корея пришла к выводу, что её выживание зависит от ядерного оружия. Может потребоваться несколько поколений, чтобы разобраться со всем этим беспорядком.

Да, эти последствия очень реальны, но они также слишком далеки от повседневной жизни американцев, которые не могут их по-настоящему ощутить. Как только машины заменят людей на поле битвы, военным ястребам станет легче убеждать общественность в необходимости бесконечных военных конфликтов.

Учитывая то, что использование ИИ может быть сопряжено с определёнными ошибками, возникает ещё одна причина для беспокойства. Системы ИИ не имеют достаточной гибкости. Они преуспели в выполнении определённых рутинных задач и распознавании определённых алгоритмических схем, но они также склонны терпеть неудачу при столкновении с новыми обстоятельствами. По словам директора программы исследований войн будущего вашингтонского Центра новой американской безопасности Пола Скарре, ИИ, как правило, очень плохо себя чувствует, когда сталкивается со сценариями, отличными от его моделей обучения. В конце концов, главная причина, по которой беспилотные автомобили столкнулись с проблемами, заключается в том, что постоянно возникают неожиданные события, которые неизбежно происходят на дороге.

Если системам искусственного интеллекта сложно ездить по оживлённым городским улицам, как они будут вести себя в условиях боевых действий? Поля сражений по своей природе связаны с высокой степенью неопределённости, там происходят постоянные изменения. Подготовить машину для такой среды особенно сложно, потому что информация об оружии и тактике противника всегда ограничена. В данных условиях можно легко представить себе ситуацию, когда система ИИ неправильно истолкует то или иное событие, что в свою очередь может привести к катастрофическим последствиям.

26 сентября 1983 года мир оказался на грани ядерного апокалипсиса. Советская система раннего предупреждения сообщила о запуске против СССР пяти американских межконтинентальных баллистических ракет (МБР). Советский офицер, получивший сообщение, зная о том, что настоящая американская ядерная атака предполагает гораздо большее количество МБР, пришёл к выводу, что сигнал о нападении оказался ложным. Смогла бы машина в подобной ситуации принять правильное решение? Исходя из предыдущего опыта, ответ — нет. Какой дорогостоящей в данном случае оказалась бы ошибка.

Поскольку системы ИИ начинают играть всё большую роль в вооруженных силах, их могут также задействовать для решения таких чувствительных ситуаций с высокими ставками, как ситуация 1983 года. Учитывая послужной список ИИ, подобная перспектива не может не вызывать обеспокоенности. Если мы поспешим внедрить ИИ, мы предоставим жёстким алгоритмам возможность решать вопросы войны и мира. И именно поэтому наши «вечные войны» могут стать поистине бесконечными.

Вернуться назад